欢迎来到

交互式人工智能(CoAI)课题组

交互式人工智能课题组(Conversational AI, CoAI)隶属于清华大学计算机系、清华大学人工智能研究院。交互式人工智能是指通过对话、问答等语言交互方式体现出来的智能行为,是人工智能最具挑战性、最综合性的技术,涵盖了语义理解、知识表示、逻辑与推理、语言生成等各个方面。

课题组现有博士生、硕士生10余人,访问学生10余人。课题组曾承担多项国家重点项目,例如863、973、自然科学基金重点项目等。此外,课题组还与众多国内外知名企业建立了广泛合作,例如华为、谷歌、微软、惠普、三星、斯伦贝谢、腾讯、阿里巴巴、搜狗、美团、好未来等。

课题组诚邀优秀的博士后、研究生、本科生加盟!同时也热烈欢迎优秀的国际学生、港澳台学生加盟!

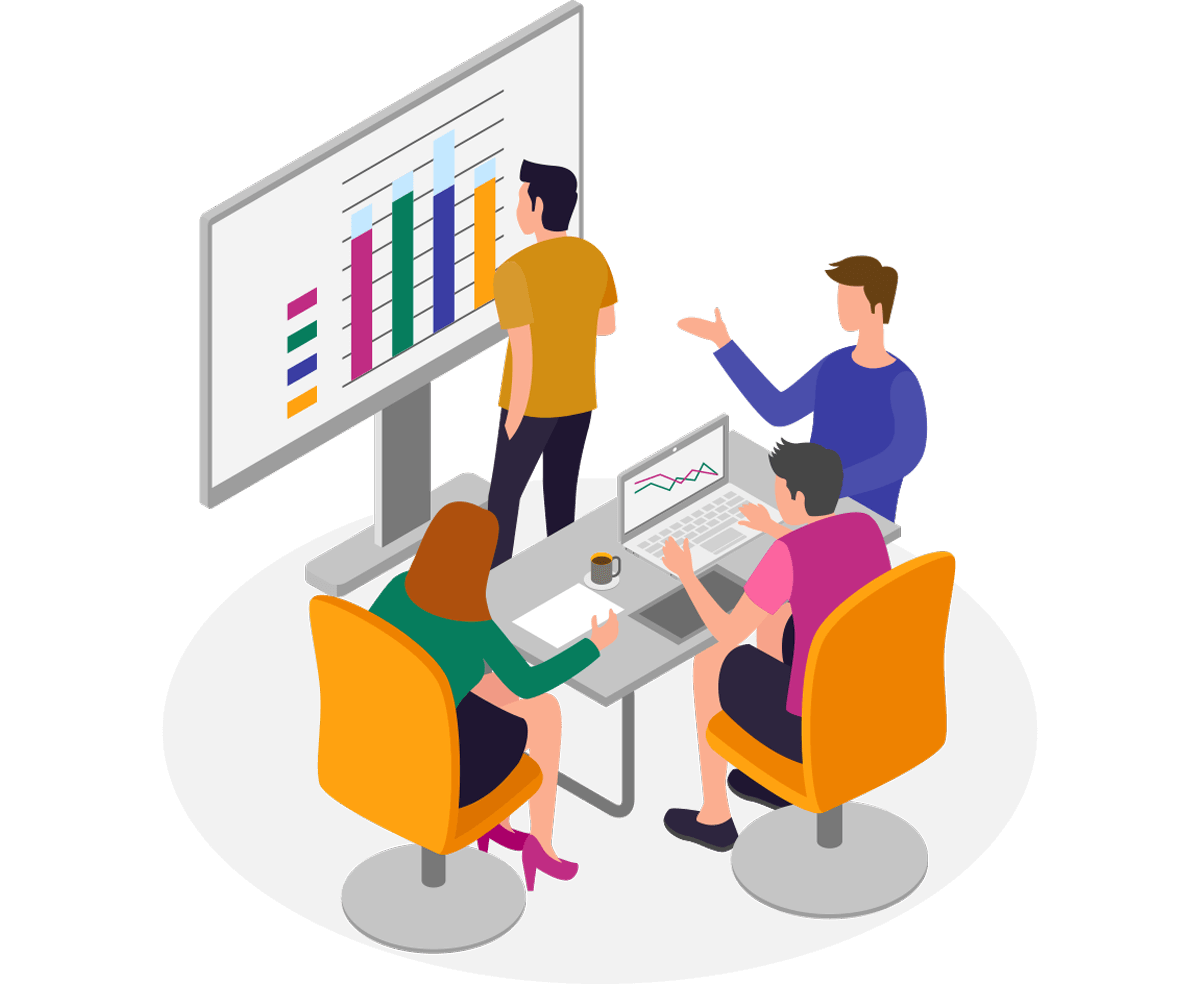

朱小燕教授

朱小燕教授

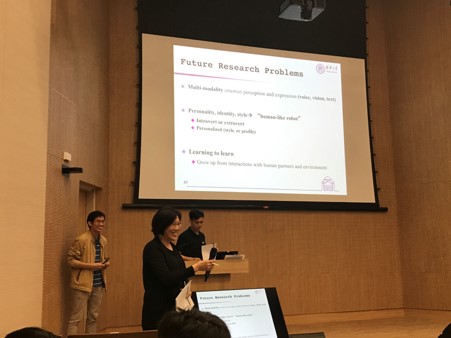

黄民烈副教授

黄民烈副教授

华为

谷歌

微软

惠普

三星

斯伦贝谢

腾讯

阿里巴巴

搜狗

美团

好未来