本工作将词级别的语言学知识(包括词性和词的情感极性)引入预训练语言模型中,提出了一种适用于情感分析任务的语言表示模型SentiLARE。该模型主要包含两个模块:1) 知识获取:通过上下文感知的情感注意力机制从SentiWordNet上获取词的情感极性;2) 知识融合:以标签感知的掩码语言模型作为预训练任务来构建知识增强的预训练语言模型。实验表明SentiLARE在各类情感分析任务上均能取得当前最佳性能。

论文链接:https://www.aclweb.org/anthology/2020.emnlp-main.567/

代码、预训练模型、数据链接:https://github.com/thu-coai/SentiLARE

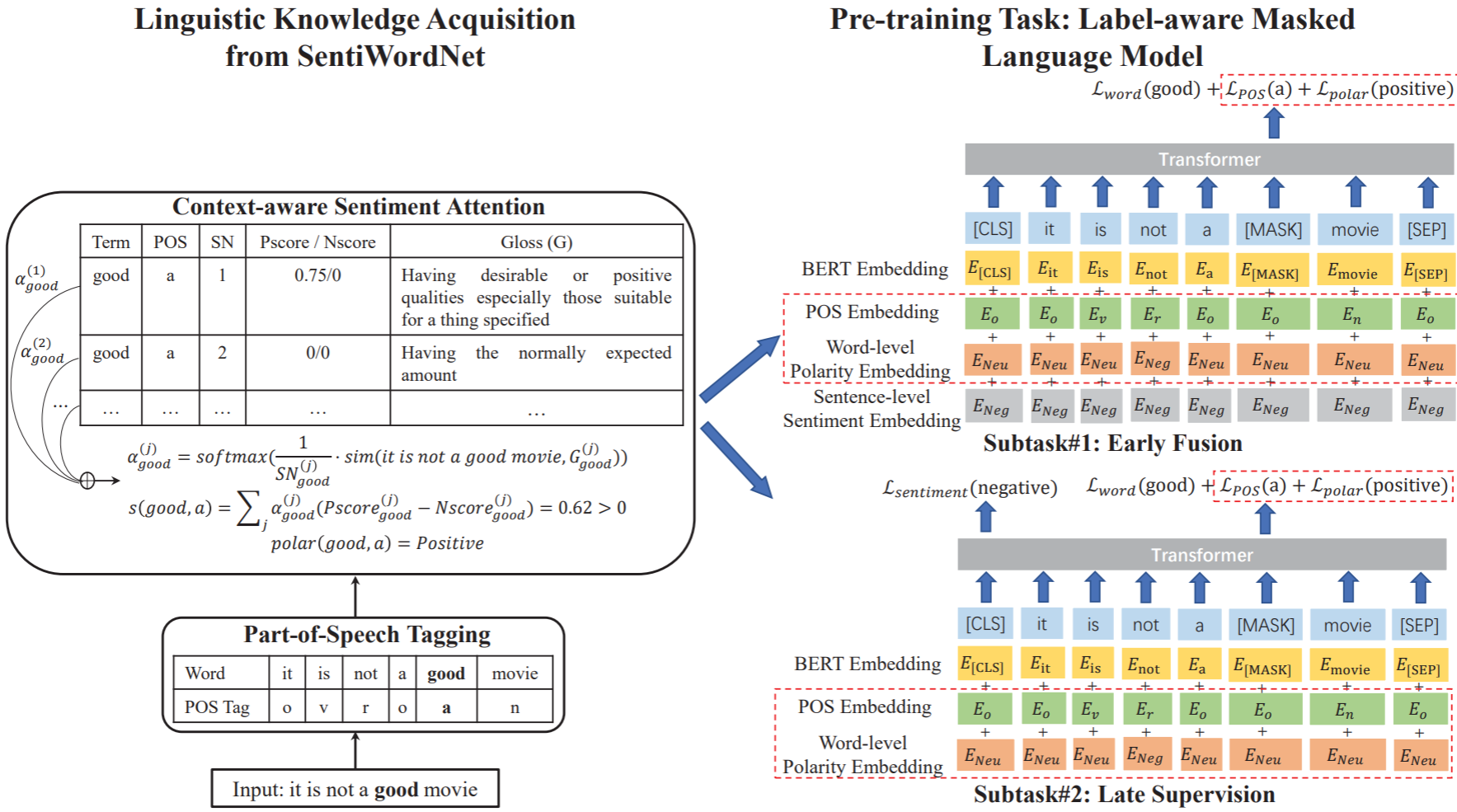

本工作将语言学知识(包括词性和词的情感极性)引入预训练语言模型,以构建适用于情感分析的预训练模型SentiLARE。该模型主要分为两个部分,即知识获取和知识融合,如下图所示。

知识获取部分的目标是获取句子中每个词的词性和情感极性。本工作使用Stanford CoreNLP对句子进行词性标注,并将标注结果合并为五个词性类别,即动词(verb)、名词(noun)、形容词(adjective)、副词(adverb)和其他(others)。然后根据每个词及其词性在语言学资源SentiWordNet中查找对应的义项,每个义项包含编号、正向/负向情感分数和词义解释等信息。为获得词级别情感极性,我们设计了上下文感知的情感注意力机制(Context-Aware Sentiment Attention),同时考虑义项的编号(编号越小意味着自然语言中使用频率越高)和词所在的上下文与词义解释的相关性,以得到每个义项的注意力权重系数。最后根据注意力权重对所有义项的情感分数进行加权,即可得到每个词的情感极性。

知识融合部分的目标是通过预训练任务的设计来获取情感感知的语言表示。我们设计了标签感知的掩码语言模型(Label-Aware Masked Language Model)来构建句子级语言表示和词级别语言学知识的关系,其中包含两个子任务,即early fusion和late supervision。Early fusion将句子级的情感标签作为模型的输入,训练目标是预测被掩盖的词及其词性和情感极性,从而显式构建句子级的情感标签到词级别语言学知识的映射关系。Late supervision则使模型同时预测句子的情感和被掩盖词的知识信息,隐式地构建了句子级语言表示和词的关系。

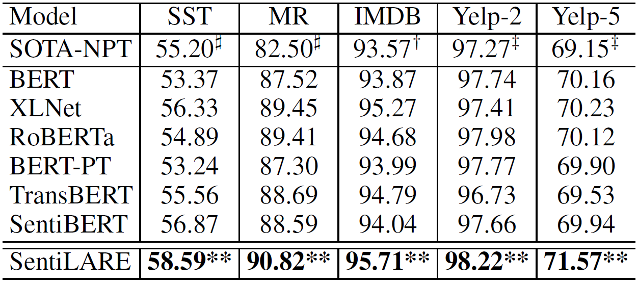

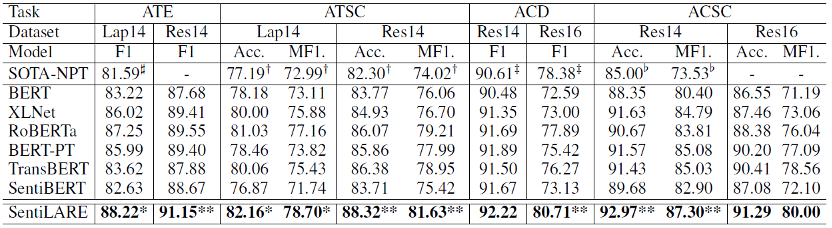

我们在句子级情感分类任务和属性级情感分析任务上验证了模型的性能,实验结果表明SentiLARE在这两类情感分析任务上均能取得当前最优性能,这说明有效利用语言学知识确实能够提升预训练模型的情感理解能力。

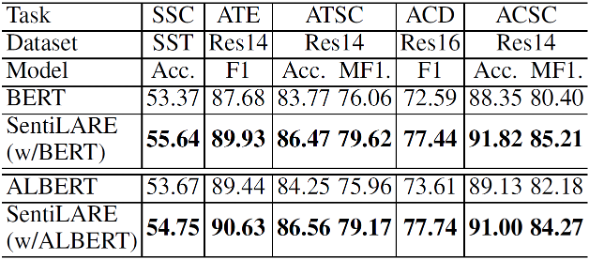

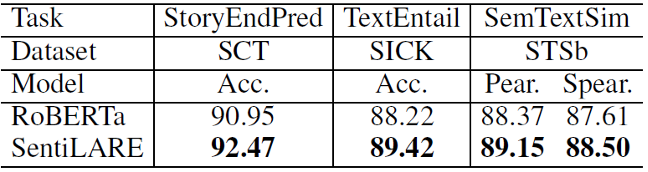

同时,我们还在不同的预训练模型框架和文本匹配任务上验证了SentiLARE的泛化性。在模型框架的实验中,我们除主实验使用的RoBERTa外还在BERT和ALBERT上进行了实验,结果表明语言学知识的获取和融合模块在各类预训练模型上均能取得一定的效果。我们还探索了SentiLARE在其他NLP文本匹配任务上的性能,如故事结局分类、文本蕴含和文本语义相似度,实验表明SentiLARE在这些任务上相比原始的RoBERTa也能有一定的提升,这说明我们的模型在不同的NLP任务上具有一定的泛化性。

更多和模型设计相关的消融实验及分析可以参考我们的论文。