7月3日,清华大学COAI小组的高信龙一同学论文《Is Your Goal-Oriented Dialog Model Performing Really Well? Empirical Analysis of System-wise Evaluation 》获得了第21届SIGDIAL最佳论文。该工作从系统层面对目标导向型对话模型进行了全面的性能评估,并提供了详细的实证分析和讨论,为对话系统的研究者和开发者提供了重要的参考建议。

会议介绍

SIGDIAL (Annual Meeting of the Special Interest Group on Discourse and Dialogue) 是对话系统领域的专门学术会议,文章针对性较强。会议由ACL下属的对话系统小组SIGDIAL主办,至今已举办21届。著名的DSTC (Dialog System Technology Challenges) 对话系统技术挑战赛便在SIGDIAL上发起,至今已举办8届。受到疫情影响,本届会议改为线上举行。会议链接:https://www.sigdial.org/files/workshops/conference21/

论文简介

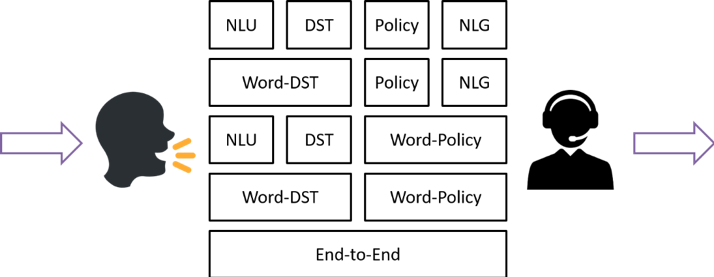

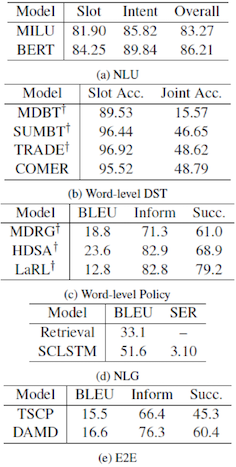

近年来,目标(任务)导向型对话系统引起许多研究者的关注。一个目标型对话系统可包括多个模块,例如一个传统的流水线模型包括语言理解、状态追踪、对话策略、语言生成四个模块,而各个模块均有大量的新算法和模型被提出。然而,大部分工作忽视了去评价一个完整的对话系统的性能。这些新算法基本只在相应模块内进行比较验证,而没有评估该算法嵌入一个对话系统中的表现。如下图所示,根据细粒度和具体模型不同,各个模块和模型之间可以有多种拼接方式组成一个对话系统。

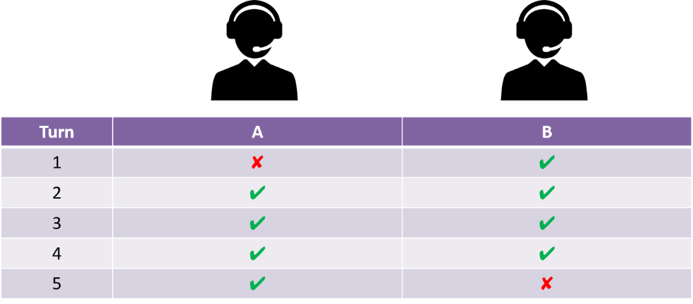

此外,模块内的评价基本只是在单轮对话的设定下进行,而一个完整的对话应当由系统和用户进行多轮交互达成的。如下图所示,面对一个长度为5轮次的对话,系统A和系统B都有80%的回复成功率。但显然系统A的表现更差,因为第一轮就预测错误的话,之后的预测得再正确都失去了意义。

故我们在本工作中尝试比较不同模块、不同细粒度、不同配置下各个目标导向型对话系统,以作系统级的性能评估。搭建完的对话系统通过与模拟用户或真实用户进行多轮对话交互,并使用对话级别的评价指标进行实验。

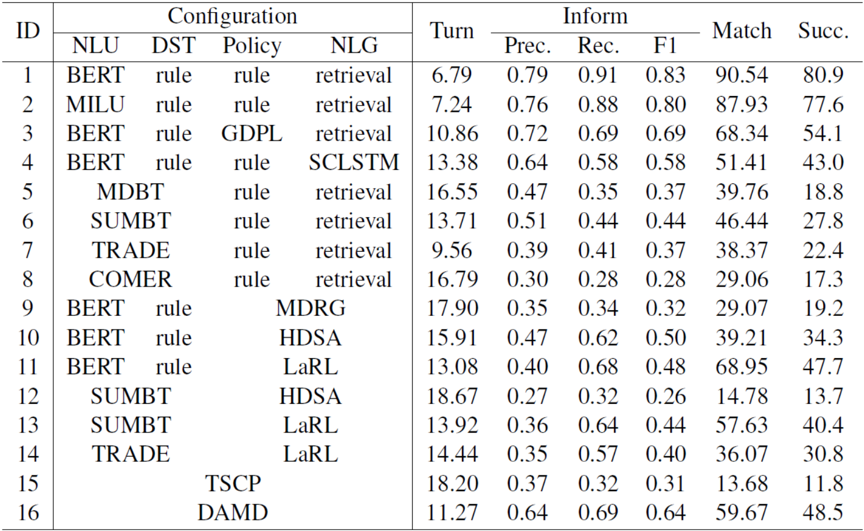

模拟评测实验表明,总体上流水线系统(1-4)比联合系统(5-14)和端到端系统(15-16)有着更好的系统性能,这是因为流水线系统利用到了更细的监督信号,同时也说明了其余系统目前技术上的缺陷。

通过和模块内的评测指标对比,发现一些模块指标和系统评测结果不一致,说明了系统级评估的必要性,同时也呼吁之后的研究能将新算法融合到完整的系统中进行评测。

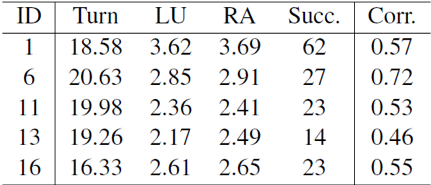

人工评测结果显示模拟评测和真人评测之间有着适中的相关程度,一定程度上说明了模拟评测作为对话系统自动评测指标的合理性。

更多的实验设定及实验结果可参考原论文:https://arxiv.org/abs/2005.07362。

个人介绍

高信龙一,清华大学计算机系2019级硕士生,交互式人工智能组成员,师从黄民烈副教授。主要研究方向为对话系统、推荐系统与强化学习。已在ACL、EMNLP、WWW等顶级会议上发表数篇论文。